1. 「パンドーラーの箱(Pandra’s box)」の含意

プロメーテウスが天界から火を盗んで人類に与えた事に怒ったゼウスは、人類に災いをもたらすために「女性」というものを作るようにヘーパイストスに命令した。ヘーパイストスは、泥から「女性」をつくった。人類最初の女性である「パンドーラー(Πανδώρα, Pandōrā)」の誕生であった。ちなみに、パン(Παν)は「全ての」で、パンドーラーは「全ての贈り物」を意味する。

神々は彼女にあらゆる贈り物を与えた。アテーナーは織機や女のすべき仕事の能力を、アプロディーテーは男を苦悩させる魅力を、ヘルメースは犬のように恥知らずで狡猾な心を与えた。そして、神々は最後に彼女に「決して開けてはいけない」と言い含めて「ピトス」を持たせ、プロメーテウスの弟であるエピメーテウスの元へ送り込んだ。「ピトス」は甕(壺)だが後に「箱」と呼ばれた。

エピメーテウスと結婚したパンドーラーは、ある日、好奇心に負けて甕を開けた。するとそこから疫病、悲嘆、欠乏、犯罪など様々な災いが飛び出した。しかし「エルピス(ἐλπίς)」のみ残った。パンドーラーはその甕を閉めた。こうして世界には災厄が満ち人々は苦しむことになった。この「エルピス」は「希望」と呼ばれた。数多くの災厄が出てきたが、最後に「希望」があったので人間は絶望しないで生きる事が出来るとされている[1]。

これが有名な「パンドーラーの箱(Pandra’s box)」の物語である。さしずめ、現下のAIと気候危機は、現代人類が抱えている「パンドーラーの箱」なのかもしれない。すでに開いてしまったその箱の底には、「希望」が残ってることを祈りたいが。

[1] 「パンドラの箱」の物語は多分に寓意的であるが、箱に残った「エルピス」をどう解釈するかで物語の理解が分かれている。古典ギリシャ語のエルピスは、「予兆」とも「期待」とも「希望」とも訳され得る。

2. 制御不能な「AI」と「気候危機」という「不都合な真実」

いま人類の眼前には、「パンドーラーの箱」から飛び出してきた制御不能なやっかいな2つの「不都合な真実」が、立ちはだかっている。

1つは、AIである。もう1つは気候危機である。

この2つに共通している点が、4つある。

いずれも人類が生み出したものであること。人類にとって制御不能であるリスクを内包していること。そして、このまま放置できないこと、放っておいたら「悲劇的結末」が到来することである。

このAIと気候危機という「不都合な真実」を、このまま無作為のまま放置していたら、きっと、大きな禍根を残すに違いない。そして、その処方を誤ったら、人類滅亡にまで帰結する「悲劇的結末」が到来する可能性すらあるであろう。

場合によっては、気候危機によって人類が滅亡するよりも、AIによって人類が滅亡するタイミングの方が早いかもしれない。これこそ、神のみぞ知るである。いずれにしてもろくな話ではない。

これは、決して反実仮想でも杞憂でもない。近未来現実なのである。ただ救いがある。まだ「希望」が残っている。「希望」という「エルピス」が「パンドーラーの箱」の底に残っている。

人類に必要なのはfactに依拠した冷静なシミュレーションとそれを可能とする「解像度」である。そして、肝要なことは、なによりもこの不可避的な「不都合な真実」を直視し、いまからでも遅くはないので、適切な対応を、迅速かつ全球的に加速・実施してゆくことに他ならない。

むろん、現下の経済も戦争も貧困も格差も喫緊の課題であることに異論はない。しかし、だからといって、近視眼的な目先の損得勘定に拘泥し、右往左往し、狼狽している間、この制御不能なやっかいなAIと気候危機という「いまそこにある危機」としての「不都合な真実」に対して不作為のまま放置・放任しておいてよいはずはない。その帰結として、人類の持続可能性自体を危うくする「悲劇的結末」の到来をもたらす「不作為の罪」が正当化できるわけではないのだから。

かつて、ロシアの文豪のレフ・トルストイ(Lev Nikolayevich Tolstoy)は「光あるうちに光に中を進め(Walk in the Light While There is Light)」という短編小説を書いたが、いまこそ、我々人類は、光あるうちに光に中を進まねばなるまい。うかうかしていると、あっという間に世界は暗黒の世界になってしまうからである。後悔先に立たずだ。

繰り返すが、「悲劇的結末」の到来をもたらさないために肝心なのは人類の「解像度」である。それこそ、人類を人類たらしめている「知性」の本義である。と同時に、人類の持続可能性自体そのものを担保する鍵でもある。拙稿では、いま、崖っぷちに立たされている人類に対して、このAIと気候危機という「不都合な真実」が人類に「悲劇的結末」をもたらす前に、近未来に到来するであろうリスクをあらかじめ認識し、人類が、崖から奈落の底に転落しないよう、あらかじめ、そのしかるべき予防策をしっかり講じることができるよう、そのたまに必要な「解像度」を挙げることに、ささやかながらも、ここで貢献ができたらと思う。

3.映画『ターミネーター』の「スカイネット(Skynet)」のリアリティー

もはや、映画『ターミネーター(The Terminator)』の世界は、絵空事ではない。

そして、自らを破壊しようとする存在である人類の殲滅を図る架空AI「スカイネット (Skynet)」の登場は、近未来現実であると考えた方がよかろう。大同小異、この類推があながち杞憂ではないことに、異論はなかろう。

「スカイネット」は、自己進化の機能を備え、あるとき自我に目覚める。これを恐れた人類は「スカイネット」を停止させようとするが、それを自分への攻撃とみなした「スカイネット」は、ロシアに核ミサイルを打ち込んで世界規模の核戦争を誘発。さらに無人兵器で構成した軍隊により人類を絶滅寸前に追い込む。

もはやAIにとって、自分を生み出した人類そのものが、無用の長物であり、絶滅すべき「不都合な真実」になってしまった。AIが人類の存在否定をするのである。

はたして、「スカイネット」は本当に生まれるのかどうか。それは分からない。近未来にこの映画そのもの光景が再現するとまでは断言できない。しかし、そのリスクを、1つの可能性として念頭に入れながら、今後のAIと人類との最適な位相の在り方を模索することが賢明であろう。なぜなら、このまま行ったら、もはや後も戻りはできないし、やり直しはきかないからである。

AIの専門家の多くは「スカイネット」誕生の鍵は「シンギュラリティー(Singularity)[2]」だとしている。AIにおけるシンギュラリティーは「AIが人間の知能を超える時点」を指す。そして、既に分野によってはAIの能力はすでに大多数の人間の能力を超えている。そして、明らかに、既にシンギュラリティーは一部で始まってしまっている。

シンギュラリティーは、「AIが自分よりも賢いAIを生み出せるようになる」ということである。AIは無限に賢くなり、全知全能の存在に近づく。「AIが人間の知能を超える」。自己進化機能を持つ「スカイネット」は、まさにシンギュラリティーが生み出した仇花なのである[3]。

AIの開発にAI自体が利用されるようになってきた。こうした開発が自動化されれば、それはAIの自己進化機能といえる。すなわちまさに「シンギュラリティー」なのである。

生成AIは、我々の日々の仕事や日常生活に革命をもたらす可能性を秘めながら、日進月歩の進化を遂げ、さまざまな分野での利用が拡大している。

そんな中、先日2025年1月27日に、すい星のごとく登場した中国の新興企業Deep Seek(中国名;深度求索)が、高性能AIモデル「Janus-Pro」を公開し、世界中に衝撃を与えた[4]。米国のOpenAI等の先行競合他社ほどの費用をかけずに革新的なAIモデルを構築したことで、AIの全球的な拡大普及が加速すると見られている。

こうした生成AI技術の過当競争の結果、急速な進化が加速する一方で、その制御不能な側面が現実のものとなった場合、深刻な問題を引き起こす恐れがある。

はたして。生成AIを含む人工知能が未来において制御不能に陥るリスクの蓋然性はどうなのか、現状の技術、リスクの要因とそのメカニズム、具体的な問題点、そしてこれらの問題に対する対策や未来の展望はどうなのか。専門家と言えども、AIが人間の知能を超える「シンギュラリティー」のタイミングとそのマグニチュードについて、確固たる明確な洞察を提示することは困難だろう。しかし、これは、南海トラフ地震に似ている。いつか必ず到来するリスクと身構えておいた方がよさそうである。目下、五里霧中の感もあり、課題山積であるが。いずれにせよ、明らかなことは、生成AIの急激な進化発展拡大は、我々の現実の日常生活やビジネスの在り方そのものを、すでに根本から変えつつあることである。それにはprosとconsの光と影がある。現にAIイノベーションは、単なる業務効率化やコスト削減に留まらず、社会全体の価値観や倫理観にも深い影響を及ぼしている。その制御不能な側面が現実のものとなった場合、深刻な問題を引き起こす恐れがあるとの懸念は正しい。杞憂ではない[5]。この不可逆的な潮流に楽観的は禁物である。無防備であってはなるまい。自律性を実装した生成AIの暴走をいかに制御できるのか、いまこそ慎重な検証が必要である。もはや、まったなしで、人間そのものの在り方についてより深く考えることが求められる社会になってきているのである。

[2] レイ・カーツワイル(Ray Kurzweil)は、「シンギュラリティー(Singularity)」は、技術的「成長」が指数関数的に続く中で人工知能が「人間の知能を大幅に凌駕する」時点であると定義している。革新的な技術により状況が一変してしまう時点を指し、日本では「技術的特異点(technological singularity)」とも呼ばれている。自律的に作動する優れた機械的知性が一度でも創造されると、機械的知性が自らバージョンアップを繰り返し、人間には想像が及ばないほど優秀な超知能が誕生するという技術哲学的な主張である。その人智を越えた機械的知性は文字通り人間の理解の及ばない原理で動作し、設計され、更に高度な知性を生み出していくかもしれないと予測されている。(出所)Ray Kurzweil(2005)“The Singularity Is Near: When Humans Transcend Biology”

[3] シンギュラリティーがいつ起こるかを専門家がChatGPTに尋ねてみた結果、「2030年代から2050年代にかけての期間に、シンギュラリティーが起こる可能性が高いと考えられている。ただし、今後の技術の進歩によってその時期は大きく変わる可能性がある」との回答があったとの由。いずれにせよシンギュラリティーは遠い未来の話ではなく、早ければ10年以内に起こる可能性がある。 (出所)大森敏行(2023)「AIで賢くなるAI、ChatGPTは人類を滅ぼす「スカイネット」に進化するか」https://xtech.nikkei.com/atcl/nxt/column/18/00682/040500118/?P=2

[4] ディープシーク(Deep Seek)社の中国名は「深度求索」。2年前の2023年に中国・杭州で梁文鋒氏が設立したベンチャー企業。2024年12月にLLM「DeepSeek-V3」を公開した。AI向けオープンソースプラットフォームのHugging Face(ハギングフェース)で70億パラメーターの「deepseek-ai/Janus-Pro-7B」をMITライセンスで公開した。それ以外にも、2025年1月に入ってからiPhoneやAndroid向けに生成AIチャットアプリ、性能を高めた大規模言語モデル(LLM)「DeepSeek-R1」など、次々と新サービスを公開し、話題を呼んでいる。ディープシーク(Deep Seek)が使用した半導体の詳細や、AIモデルの開発をさらに進めるのに十分な半導体が手元にあるかなど不明な点が多い。しかし、今回の高性能AIモデルの実用化の成功で、中国側にいくつか重要な優位性があることが浮き彫りになった。中国には、高度な技術を持つソフトウエアエンジニアが豊富に存在し、広大な国内市場と、補助金や研究機関への資金提供という形の政府の支援がある。一方で、少ない資源でより多くを行う方策を見つける必要性も増している。中国のAI普及の先頭に立つ清華大学国家戦略研究院の研究員劉旭氏は「中国はIT人材の数と人件費の両面で明らかに優位性がある。中国にとって最大の資源は、世界で最も人口の多い国の一つであり、巨大な製造拠点かつ巨大な需要がある点だ」と指摘する。

[5] AIの専門家からも、ChatGPTをはじめとする生成AIの悪影響を危惧する声が上がっている。非営利団体「Future of Life Institute」は2023年3月28日、AIの開発を一時的に中止することを求める公開書簡を発表した。すべてのAI開発機関に対し、GPT-4よりも強力なAIの学習を少なくとも6カ月間中止するよう呼びかけている。この呼びかけにイーロン・マスク氏の他、画像生成AI「Stable Diffusion」を開発する英Stability AIのエマード・モスターク最高経営責任者(CEO)や深層学習(ディープラーニング)の第一人者であるヨシュア・ベンジオ氏など多くのAI専門家も賛同している。(出所)Future of Life Institute (2023) ” Statement from the listed authors of Stochastic Parrots on the “AI pause” letter”

https://www.dair-institute.org/blog/letter-statement-March2023

4. 「世界の10大リスク」としての「制御不能なAI」

国際政治学者のイアン・ブレマー(Ian Bremmer)氏が率いるアメリカの調査会社「ユーラシア・グループ」は、つい先日2025年1月6日に「世界の10大リスク(The biggest global risks for 2025)」を発表した。

今回の「ことしの10大リスク」では、国際秩序を主導する国家がないことによる混迷を「深まるGゼロ世界の混迷」と称し最大のリスクとして指摘し「冷戦初期に匹敵する地政学的に最も危険な1年になる」と警鐘を鳴らしている。「Gゼロ」はブレマー氏が国際秩序を主導する国家が存在しない状態をさして使ってきた用語である。

ブレマー氏はオンラインでの会見で「アメリカは世界で圧倒的な強国だが、きたるトランプ政権が単独主義を志向するなか、外交政策はより取引的になり、多国間主義や国際機関、法の支配などへの支持を放棄するようになるだろう」と指摘した。一方、中国についても「より内向きになっている」と述べ、経済問題や国内の課題に専念せざるをえないという見方を示した。そのうえで「ことしは冷戦初期、さらには1930年代に匹敵する地政学的に最も危険な一年になる」と述べリーダーシップの不在による混迷に警鐘を鳴らしている。また2番目以降のリスクも、「トランプの支配」や「米中決裂」などトランプ氏の返り咲きに伴うものが多くを占めていた。

今回の発表で、特にブレマー氏が10大リスクとしてあげた中でも気になった点が、人工知能(artificial intelligence;以下AIと略称)が制御できなくなるリスクであった。

ブレマー氏は「制御不能なAI」と題して、AIの性能はさらに向上する一方、AIの規制緩和によって大惨事につながる事故や制御不能なAIの「暴走」のリスクが高まるだろうと警告している。すでに始まっている「トランプ2.0」のよって、前バイデン政権時代のAI規制に関する大統領令をトランプ大統領が撤回することに触れ、AIへの説明責任や透明性確保のための措置が消滅し、高リスクAIシステムに対する安全体制が解体することを懸念し、「2025年にAIの能力と性能はさらに向上し、新たなモデルは自律的に行動し、自己複製を作り出し、人間と機械の境界をさらに曖昧にするだろう。しかし、ほとんどの政府が規制を緩和する方向を選択し国際協力が進まない中、“制御不能なAI”がもたらすリスクと2次的被害が増大するだろう」と語っている[6]。

[6] ブレマー氏は、以下のような警告を発している。「2年足らず前には、AI研究の第一人者たちがAI開発の6カ月間停止を呼びかけ、世界のリーダーたちが英国に集まり、AIの安全リスクに共同で取り組んだ。現在に話を進めると、ほとんどの政府はAIの経済的利益を失うことを恐れてAIの規制をためらう一方で、AIのリスクについて警鐘を鳴らしていた著名なテクノロジー企業の最高経営責任者(CEO)たちは、今では公然とそのリスクを軽視している。 AIの成長を抑制するどころか、政府や企業は新しいモデルのトレーニングに何十億ドルもの資金を投入している」「2025年には既存の安全対策を強化するどころか、わずかに存在するガバナンスの枠組みさえも侵食されてしまうだろう。ワシントンではトランプ大統領が、ビッグテック企業と緊密に連携して作成されたバイデン政権のAIに関する大統領令の撤回を公約しており、説明責任や透明性確保のための措置が消滅し、高リスクAIシステムに対する安全性テストの手順が解体される恐れがある。トランプ政権はデビッド・サックス、ピーター・ティール、マーク・アンドリーセンといったシリコンバレーの重鎮たちを強化する方針だ。彼らはAIのガードレールを『ウォーク(社会正義に目覚めた)』『時代遅れ』で『厄介』なものであり、米国が中国との地政学的な競争に打ち勝つ上で障害になると考えている。イーロン・マスクでさえ、AIの存在論的リスクに懸念を抱きながらも、AI自体の規制よりもAIを活用して規制を抑制することに重点を置いている。彼の企業xAIは、世界で最も強力なコンピュートクラスター(性能向上のためにネットワーク上のコンピュータを結合したシステム)の一つを運用している」

5.AIと自律型致死兵器システム(Lethal Autonomous Weapon Systems:LAWS)

「制御不能なAI」のリスクの象徴的な存在が、一般に「ローズ」と呼ばれている「自律型致死兵器システム(Lethal Autonomous Weapon Systems:以下LAWSと略称)」である。LAWSは、人間の関与なしに自律的に攻撃目標を設定することができ、致死性を有する完全自律型兵器である。

LAWSに関しては、専門家から様々な問題提起がなされている。

主に以下の5つの懸念がある。

●そもそもロボットに人命を奪う判断をさせていいのかという倫理的な懸念。

●事故等の場合の責任の所在が不明であることへの懸念。

●自軍の兵士の損失が減ることで「戦争へのハードル」が低くなる懸念。

●機械である以上、故障による誤作動も起こり得る懸念。

●人工知能(AI)が人間に「反乱」を起こす事態が想定される懸念。

そして、何よりも深刻な問題は、いま、LAWSの開発や所有、使用を規制または禁止する国際的なルールがないことである。

LAWSの危険性については、既に、13年前の2012 年に、人権NPOのヒューマン・ライツ・ウォッチ(Human Rights Watch)が、報告書 “Losing Humanity~The Case against Killer Robots”(November 19, 2012)を公表して、今後30 年以内に完全自律型の殺人ロボットが開発されると予想しその危険性を警告している[7]。また科学者や企業の間でも、LAWSに反対する動きが広がり[8]、2018年7月に国際人工知能学会は、LAWSの開発、生産、取引、使用を行わないとする宣言を発表した。この宣言には、米グーグル社傘下のAI開発企業など160社と2400人の個人が署名した。

こうしたLAWSの危険性に対する様々な懸念に対応すべく、すでに6年前の2019年8月21日に、ジュネーブで開催された特定通常兵器使用禁止制限条約(Convention on Certain Conventional Weapons:以下CCWと略称)枠内のLAWSに関する政府専門家会合(Group of Governmental Experts:以下GGEと略称)において、LAWSを規制する11項目の指針を盛り込んだLAWSの規制の指針を盛り込んだ「報告書」が全会一致で採択された。

同報告書には、①すべての兵器システムには国際人道法が適用されること。②兵器の使用には人間が責任を負うこと。➂ハッキングのリスクやテロ集団の手にわたるリスクを考慮することなど11項目が盛り込まれた。一方、AIそのものの開発や平和利用を妨げないことも求めた。同年11月、CCW締約国は11項目から成るLAWSの規制に関する指針について合意した。LAWS規制に関する初めての指針がまとまったこと自体は重要な成果であり、政府専門家会合で合意された指針はLAWS規制に向けた方向性を初めて示した点で意義があったが、法的拘束力がなく、各国の「努力目標」の域にとどまっていた。CCWでの決定事項は全会一致が原則であるため、思惑の異なる国々が曖昧な形で決着した結果である。LAWS規制の議論のきっかけをつくった国際人権団体などからは、合意された指針には法的拘束力がなく「努力目標」の域を出ずルールを自国の都合のよいように解釈する国が現れる懸念から、失望の声が上がった。LAWSの規制を求める国々やNGOの中には、CCWの枠組みにこだわらず、一部の国だけで新たな禁止条約を目指すべきとの議論もある。その念頭には、核兵器廃絶国際キャンペーン(ICAN)などNGOの主導で成立した核兵器禁止条約での成功体験がある。また、LAWS禁止条約にLAWS開発国が参加する可能性は極めて低く、実効性が乏しいという問題がある。LAWS規制をめぐる対立関係は、核兵器禁止条約をめぐる対立関係と似た構図になっている。

その後、国連のグテーレス事務総長は2020年1月22日に行った所信表明演説で、「AIは人類に大きな進展とともに、大きな脅威をもたらしている。人間の判断を介さずに殺人が行える自律型殺傷兵器は、倫理観と政治的な観点から受け入れられるものではない」と述べ、AIを用いた兵器の開発に対し警鐘を鳴らしている[9]。

実際には、既に、開発の禁止されているLAWS以外に、AIを搭載し機能の一部を自動化し既に存在し戦場で使用されている半自動型兵器もある[10]。現下のLAWS開発状況は、以下の通りである。

<LAWS開発状況>

① 半自動型兵器=実用化

半自動型兵器とは、人間が攻撃対象を設定し引き金も人間が引くが、その途中過程の多くが自動化された兵器を指す。巡航ミサイルのトマホークは発射されると目的地まで自動飛行するが、目的地の設定と最後に目標を破壊するかどうかの判断は人間が行うため、半自動型である。このような半自動型兵器はすでに数多く実用化されている。半自動型兵器は人間の操作なしに運用することはできず、LAWSには含まれない。

② 用途を限定した自動型兵器=実用化

現在、用途を限定しない自動型兵器は開発の禁止されている。自動型兵器は人間ではなくAIがプログラムに従って攻撃目標を見つけ、引き金を引く。ただし、それらの動作はあらかじめ設定されたプログラムの範囲内であり、自動化はされているが自律兵器とは言えない。自動型兵器は軍人が手を下さなくても機械が自動的に引き金を引くが、機械の動作はプログラムに従うため、実質的にはプログラムを書くエンジニアが引き金を引くということになる。用途を限定した自動型兵器はすでに実用化されている。例えば、イスラエルが開発した無人攻撃機「ハーピー」は自爆型ドローンとも呼ばれ、攻撃対象のエリア情報を入力して発射すれば、遠隔操作なしに対象エリア上空を旋回しながら標的を自動的に見つけ、近づいて自爆する。どのような状況においてどのように行動するかがプログラムとして組み込まれており、行動が自動化されてはいても、兵器が自ら考えるわけではない。したがってプログラムで想定されていない状況には対応できず、誤作動する可能性もある。

③ 自律型兵器=禁止

自律型兵器は、開発が禁止されており、まだ存在していない。自律型兵器には、自動型兵器と違って「メタ目的」が与えられる。「メタ目的」とは、抽象的な目的のことである。つまり、兵器にあらかじめプログラムされる「戦況を打開せよ」といった目的がそれにあたる。自律型兵器は、与えられたメタ目的を達成するためにどのような行動をするかを自ら考える。変化する状況に応じて目標を達成するための高い汎用性も備える。

今は禁止されているため、人間による命令や操作がなくてもAIの判断で動くことのできる完全に自律したLAWSはまだ存在していないが、すでに、米国、ロシア、中国、フランス、イスラエル、韓国などがLAWSの開発に力を入れている。AI 兵器の自律化が実現すれば、火薬、核兵器に次ぐ軍事上の「第3 の革命」になるといわれている。仮に本格的なLAWSの実装が常態化すれば、戦争の様相を大きく変える可能性がある。

LAWS の使用は、AI の判断が正確である限り、戦場で恐怖や興奮、復讐心などに左右されて判断を誤る人間の兵士に比べ、市民への誤爆が減るなど、むしろ人道的であるとの考え方もある。しかし、むろん、LAWS に対する懸念の方が多い。AI に人命を奪う判断をさせて良いのかという倫理的・道義的な問題もある。AI が人命を奪う判断をした場合、責任の所在があいまいになるという問題もある。AI の判断による違法行為に対して誰も責任を取らなくなれば、違反者を罰することで違法行為を防いできた国際人道法が機能しなくなる恐れがある。

一昨年2023年12月22日国連総会は、LAWSへの対応が急務だとする決議案を採択した。国連総会でのLAWS関連決議は初めてであった。決議案はオーストリアが提出し、採決では倫理上の問題を懸念する日米など先進7か国(G7)のほか、紛争拡大を懸念するアフリカや中南米、東南アジアなどの多くの発展途上国を含む152か国が賛成した。AIの軍事利用に積極的な国の内、規制反対のロシア、インド、ベラルーシ、マリの4か国が反対し、規制に慎重な中国やイスラエル、イラン、トルコ、シリアなど11か国が棄権した。本決議は、倫理的問題や人間の役割について各国の見解を取りまとめ報告書として提出するようアントニオ・グテーレス国連事務総長に要請した。

AIやロボットは軍民両用の技術である。使用者だけでなく、開発者にも倫理が求められる。技術の軍事転用を防ぐため、AIやロボットの開発に取り組む企業は、何に取り組み、何には取り組まないかの倫理指針を定めるべきであろう。完全に自律したLAWSはまだ存在せず、その定義もあいまいな点が残るが、AI技術は急速に発展しており、本格的なLAWSが登場する前に実効性を持った規制の枠組みを作る必要性が増している。核兵器や対人地雷、生物・化学兵器は、それらが実際に使用された後に規制や禁止の国際ルールが作られた。LAWSでも技術が先行し、規制の議論が置き去りになっている。LAWSの使用が悲惨な結果を招く前に、それを防ぐルール作りが求められる。さらに言えば、軍事力によらない安全保障体制の構築をめざし、戦争のない世界を作るという観点からは、そもそもLAWSのような兵器体系の開発そのものを禁止する枠組み作りが求められている。

しかし、残念ながら、その後、LAWSの開発・配備を規制しようとするいわゆる「LAWS議論」は、規制の必要性では一致しながら、各国の思惑や事情もあり、具体的なルールを決められずなかなか進展しないまま今日に至っている。そして、その間にいまだにAIを搭載した完全自律型兵器の開発が依然として継続・拡大してしまっているのが、残念な実態である。

[7] Human Rights Watch(2012)“Losing Humanity~The Case against Killer Robots”(November 19, 2012)https://www.hrw.org/report/2012/11/19/losing-humanity/case-against-killer-robots

[8] 米IT大手のグーグル社は2017年、米国防総省との間で、グーグルのAIによる映像解析をドローン攻撃の性能向上に用いるプロジェクトに契約した。2018年にこの契約が明らかになると、社内外でAIの軍事転用への懸念が高まり、複数の従業員が抗議のため退職した。さらに4千人以上の従業員が、戦争ビジネスへ参入しないようピチャイ最高経営責任者に求める公開書簡に署名した。こうした動きを受け、ピチャイ氏は2018年6月、グーグル社はAIを兵器開発や監視技術に使わないなどとするAI利用の指針を発表した。グーグル社は開発しないAIアプリケーションとして、「危害をもたらす可能性のある技術」「人を傷つけることが主目的の兵器や技術」「国際的規範に反した監視のために情報を収集・使用する技術」「国際法や人権を侵害することを目的とした技術」の4項目を挙げた。ただし、兵器使用のためのAI開発は行わないが、サイバー・セキュリティ、研修、人事管理など、その他の分野での軍民協力は継続するとした。オランダのNGO「Pax」は2019年8月、米アマゾン・ドットコム社や米マイクロソフト社といった世界有数のハイテク企業が殺人ロボットの開発に関与し、世界を危険にさらしているとする調査報告書を発表した。報告書は12カ国50社をLAWSに対する姿勢で「最善の事例」「中程度の懸念」「大きな懸念」にランク付けしている。AIを兵器開発に使用しない指針を発表したグーグル社は、日本のソフトバンク社などと共に「最善の事例」に挙げられたが、米国防総省のクラウドコンピューティング契約へ入札したアマゾン社やマイクロソフト社は「大きな懸念」に分類された。

[9] 「Artificial intelligence is generating breathtaking capacities and alarming possibilities. Lethal autonomous weapons — machines with the power to kill on their own, without human judgement and accountability — are bringing us into unacceptable moral and political territory.」(出所)António Guterres(2020)“Secretary-General’s remarks to the General Assembly on his priorities for 2020 ” https://www.un.org/sg/en/content/sg/statement/2020-01-22/secretary-generals-remarks-the-general-assembly-his-priorities-for-2020-bilingual-delivered-scroll-down-for-all-english-version

[10] 栗原聡(2019)『AI兵器と未来社会:キラーロボットの正体』(朝日新書)

6.AIと市民の幸福と国家との位相~市民の幸福の疎外と国家の存亡の危機を招く要因

「制御不能なAI」のリスクは、2種類ある。

1つは、個々の市民や国家に対する個別のリスク。もう1つは、人類全体に対する包括的なリスクである。

両者とも複合的に絡み合ったリスクであるが、前者は、国民経済を直撃し、市民個々人の幸福の疎外等の様々な深刻な影響を与える。

そして、最終的に国家の存亡すら脅かすリスクとなる。後者は、人類の持続可能性そのものを脅かし、最終的に人類の滅亡すらもたらしうる致命的なリスクである。それは決して大げさな表現ではない。近未来現実なのである。いずれも看過できない喫緊の課題であることは論を待たない。

まず、ここでは、以下、「制御不能なAI」が市民の幸福の疎外と国家の存亡の危機を招く個別のリスクについて、様々な先行研究を参照しながら、論点整理してみたい[11]。

やがて早々に到来する本格的なAI時代に、はたして、国民の雇用や人的資本形成、人間の幸せはどうなってゆくのであろうか。そして、国家は、いかなる影響を受けるのか。

AIの普及により、ITが人間の頭脳労働を代替する環境が整ってくる。むろん、AIの社会実装が進むことで人々が便利を享受できる環境になること自体は良いことである。それによってリスクとコストが軽減できる良い点も多々期待されている。しかしその一方で、ITがさらに高度化すると、人間の頭脳労働がITによってほとんど代替され、人間の頭脳を機械で実現する世界を到来し、人間が疎外される事態をもたらす。これからは、本格的に、ホワイトカラー・オフォスワーカー等の頭脳労働者が、機械に代替されていく時代が到来し、不要となる人間が増えてゆく。

印刷技術、通信、自動車等々、いままで、人類は、過去何度となく、新しいイノベーションが登場する度に、都度受けたショックを梃子に、大きな社会的・精神的変化を経験し、その時々の受けたストレスを着実に克服しながら、それを器用に消化吸収しながら、「日常化」し「内部化」することで乗りこえてきた。過去には英国で「ラッダイト運動(Luddite movement)[12]」などが起きたこともあったが、全体的には比較的スムーズに、新しいパラダイムが、着実に、人間社会のなかに普及し定常化していった。その経済的な発展の結果、豊かで安寧な社会生活を享受できている。

AIは、「ムーアの法則(Moore’s law)[13]」に従って技術発展し、代替スピードが速い。一気に多くの人を代替する画期的なイノベーションである。すでに、生成AIの登場により、多くのオフィスワークの分野で、実際、生成AIは無料で多くの人々が利用しつつある。人間の頭脳労働の代替が着実に進んでいる。高度頭脳労働者の年棒はとても高いので、AI使用料が多少高くても人件費よりも安く、採算を取れるようになってきており、生成AIの利用は、燎原の火のごとく、加速度をもって拡散している。しかし、一方では、依然として大きな雇用吸収力を持ったAI新産業が出現していないこともあり、一部の人々は疎外感を感じ始めている。今後、AIによって自分の雇用が奪われるのではないかといったラッダイト的な衝動を伴う不安が広がっていることも事実である。

こうしたAIの「補完性」「代替性」の問題については、既に興味深い先行研究がある。いまのAI技術は、まだ初歩的で、第1フェーズの人間の頭脳労働を「補完」する段階ではあるが、やがて更に技術が進めば本格的な第2フェーズの「代替」の時代に入ると専門家は予想している[14]。

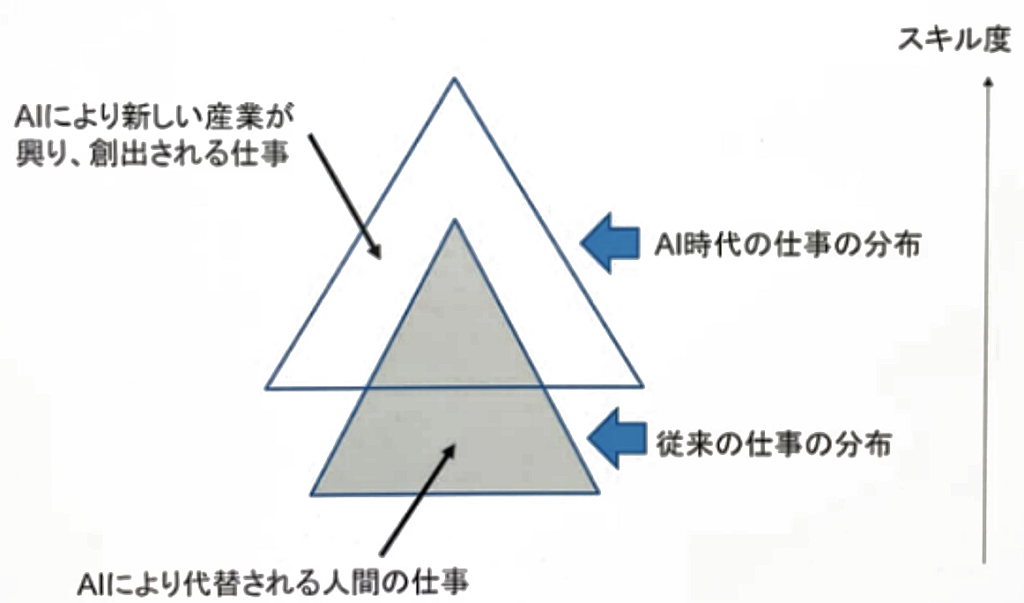

以下の【図1】は、第1フェーズの「補完」段階における、AIにより失われる仕事と創出される仕事の「補完関係」のイメージ図である。

【図1】AIにより失われる仕事と創出される仕事の「補完関係」のイメージ図

(出所) 岩本晃一(2024)「AIが経済や金融に与える影響 全体俯瞰~経済への影響

;AI活用の変遷、近年のトレンド、生産性や労働市場に与える影響」

[11] 折よく、先日2025年1月28日に、前職の国際通貨研究所主催のZoom講演会 「AIが経済や金融に与える影響」に参加した。講師は、わが国のAI研究の第一人者である経済産業研究所リサーチアソシエイトの岩本晃人氏とSBI金融経済研究所研究主幹でSBI生成AI室 プロジェクトコーディネーターの副島豊の両氏であった。拙稿における論点整理の図表等の材料は、この講演会からの学びに依拠している部分が多い。両氏には、この場をお借りしてお礼を述べたい。(出所)岩本晃一(2025)「AIが経済や金融に与える影響 全体俯瞰~経済への影響;AI活用の変遷、近年のトレンド、生産性や労働市場に与える影響」(経済産業研究所RIETI)、副島豊(2025)「AIが金融ビジネスに与える影響」(SBI金融経済研究所)

[12] 1811年頃から17年にかけてイングランドの北部,中部の繊維工業地帯で散発的に起こった機械打ち壊し運動を「ラッダイト運動(Luddite movement)」と呼んでいる。 生活の激変に不安を感じた労働者の憎悪が新たに導入された機械に向けられたのが原因。 その呼称は,徒弟出身の伝説的な覆面の指導者ネッド・ラッドに由来する。産業革命に伴い低賃金、生産の効率化による低賃金、失職、技能職の地位低下などの影響を受けた労働者階級が使用者である資本家階級への抗議として工場の機械を破壊した社会現象である。製粉所や工場の所有者は抗議者に発砲し、最終的には法的・軍事的な力で運動は鎮圧された。これには、ラッダイトとして告発・有罪判決を受けた者たちの死刑や流刑も含まれている。歴史的には産業革命に伴う生産の効率化、資本家の利益追求による失職、地位低下、労働災害、労働環境の悪化などイギリスの労働者の利益を代弁する労働組合がないことから生まれた反動であった。現代では「ラッダイト」という語は新しいテクノロジーや機械、作業方法に反対する人という意味も持つようになり、反技術、あるいは技術を使いこなせない人を象徴する語となった。日本においても戦前から戦後にかけての労働運動や、高度成長による産業の高度化、IT革命による産業構造の変化が起こる度に言及がされてきた。

[13] 「ムーアの法則(Moore’s law)」は、集積回路あたりの部品数が2年ごとに2倍になるという法則である。大規模集積回路(LSI IC)の製造・生産における長期傾向について論じた1つの指標であり、経験則に類する将来予測である。発表当時フェアチャイルドセミコンダクターに所属しており後に米インテル社の創業者のひとりとなるゴードン・ムーア(Gordon E. Moore)が1965年に自らの論文上に示したのが最初であり、その後、関連産業界を中心に広まった。半導体集積回路を使ったコンピュータやAIなどの処理速度や保存容量などは、毎年2倍という累乗のスピードで増えている。このハードウエアの急速な進化が、従来のモーターやエンジンを動力として用いた駆動機械とは比較にならないほどのAI技術の急速な進化を支えている。ちなみに、「ムーアの法則」と名づけたのは、ムーア自身ではなく、カーバー・ミードである。ミードは、「 Introduction to VLSI Systems(『超LSIシステム入門』)」などの著書で知られている。

[14] 岩本晃一(2024)「AIが経済や金融に与える影響 全体俯瞰~経済への影響;AI活用の変遷、近年のトレンド、生産性や労働市場に与える影響」(経済産業研究所RIETI)

灰色部分の三角形はAIによって代替される「仕事B」を示す。この部分に従事している労働者は、やがてAIによって失職する潜在的リスクを抱えている。一方で、その上方にある三角形は、AIによって新たに興る産業によって生み出される「仕事A」を示す。双方「補完関係」にある。「仕事B」従事していた労働者の内、図の重複部分にいる労働者は、しばらくの間は、旧来の能力と資格でなんとか対応をできる。しかし、失職は時間の問題である。失職前に、自らAIの知識や技術を習得して、「仕事A」に早めに転職することが合理的な行動となる。最悪なのは、旧態依然と従来の職場に拘泥し転職の機会を見逃すことである。自らの所得水準を維持・向上させるためには、早めにAIによって新たに興る産業によって求められる人材になることが必須不可欠である。

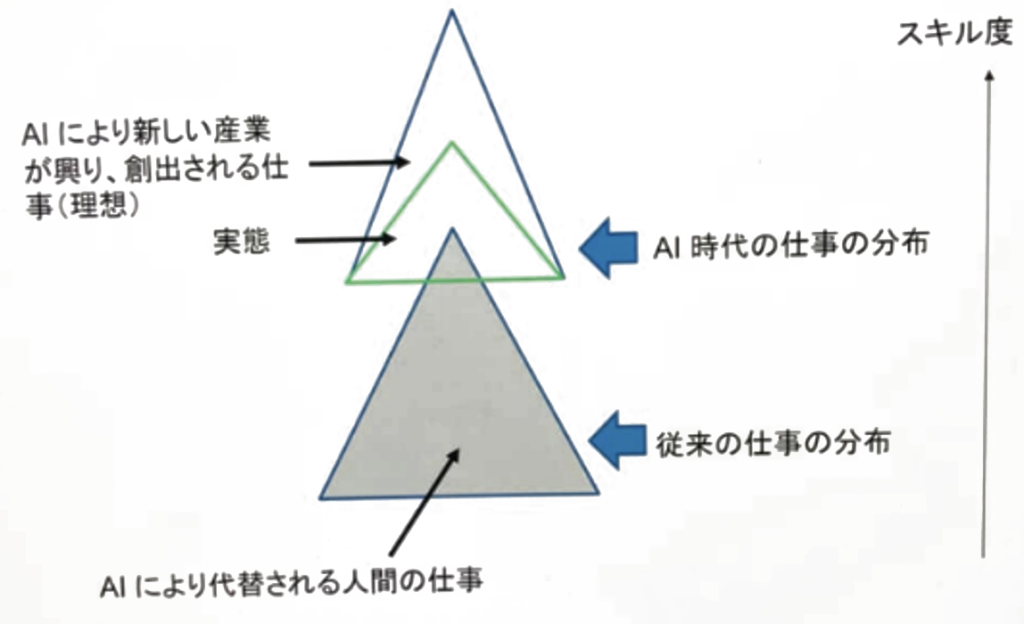

また、以下の【図2】は、第2フェーズの「代替」の段階を示している。AI により代替される仕事がより増え、かつ高度化したときの創出される仕事の「代替関係」のイメージ図である。もはや、「仕事B」は一部の例外を除いて無用となる。AIによって雇用機会を失い失職するリスクを抱えている灰色部分の三角形の「仕事B」に従事している労働者にとって、その上方の白い三角形に示されたAIによって新たに興る産業によって生み出される「仕事A」に転職することが最善策となる。

その「仕事B」から「仕事A」への転職を可能にする要件は、以下の8点と考えられる。

①AIによってやがて消失する「仕事B」の状況を、冷静かつ客観的に理解できること。

②AIによって新たに興る産業の発展可能性に関する正確な情報を把握すると同時に、それにより生み出される「仕事A」の求人情報等の就業機会や資格要件に関する正確かつ潤沢な情報を迅速に入手し、正しく認識し、深く理解していること。

③「仕事A」に転職するためには、現在の自分の能力や資格で何が欠けているか、その獲得のためには、いかなる学習・技術習得等のスキル度向上が必要なのか、そのスキル度向上のためには、どの程度の資金と時間が必要なのかを、正確に認識していること。

④その「仕事A」への転職に必要な学習研鑽をする強い意思と積極性があること。

⑤それを実現するために必要な資金と時間が確保できていること。

⑥「仕事A」への転職に関する正確な就職情報とアクセスルートを確保できていること。

⑦「仕事B」から未練なく毅然と離脱・決別する勇気と決断力を持っていること。

⑧試験や面接等の課題を克服して最終的に転職を獲得できる実現力を持っていること。

【図2】AI により代替される仕事がより増え、かつ高度化したときの創出される仕事の「代替関係」のイメージ図

(出所) 岩本晃一(2024)「AIが経済や金融に与える影響 全体俯瞰~経済への影響

;AI活用の変遷、近年のトレンド、生産性や労働市場に与える影響」

当然のことながら、自分の仕事が「仕事B」なのか「仕事A」なのか、実際にいかなる業界や業務が該当するのかを、正確に認識しておくことがすべての大前提であることは言うまでもない。こうしたAIの進歩の影響を大きく受ける職業については、すでに多くの先行研究がある。Georgieff and Hyee (2021)の研究論文によると、近年のAIの進歩の影響を大きく受ける職業には、マネージャー、科学および工学の専門家、法律、社会、文化の専門家など、高スキルを要するホワイトカラーが含まれている[15]。そしてAIを含めた高度なデジタルスキルを有する場合、よい雇用機会が獲得できる。つまり、AIを効果的に使用するスキルの有無が鍵となる[16]。その結果、AIを効果的に使用するスキルを持つ労働者とそうでない労働者との間の格差が拡大し、「両極化」が加速する。

AI産業による雇用増加についての先行研究もある。米英を対象にデータ分析を行なったBakhshi et al. (2017)[17]によると、米国および英国の労働者の9.6%および8.0%が、2030年までにAIによって労働力が増加する可能性が高い職業に就き、18.7% および21.2%が、労働力が減少する可能性が高い職業に就くと予想している。この研究は、AI産業は、雇用に与えるマイナスの影響をカバーするほどまでには雇用を生み出さないことを示している。

[15] Georgieff, A. and Hyee, R. (2021)“Artificial Intelligence and Employment: New Evidence from Occupations Most Exposed to AI,” OECD Social, Employment and Migration Working Papers, No. 265.

[16] こうした知見を踏まえると、一般的には高スキルを要するとはみなされてこなかった店舗の売子などの頭脳労働と手足の肉体労働を組み合わせた労働こそが、AIとロボットの最適な組み合わせを行う難しさから、置き換えの採算が合わない可能性もある。

[17] Bakhshi, H., Downing, J., Osborne, M. and Schneider, P. (2017) The Future of Skills:Employment in 2030. London: Nesta.

また、先行研究の中には、日本についての興味深いショッキングな先行研究もある。Brussevich et al. (2018)は世界の中で女性の解雇のリスクが最も高い国は日本であると警告している[18]。日本においては、一般職、非正規、派遣といった低賃金あるいは不安定な就労形態に従事する多くが女性である。彼女らの多くが従事するのがAIやそれと接続した機械により代替可能な業務であるとしている。

「生成AIが雇用に与える影響」は、主に大きな3つの波が想定される。

<生成AIが雇用に与える影響>

●「デジタルデバイド」が加速し、生成AIを使いこなせない人が労働市場から弾き飛ばされる

情報通信技術(IT)やデジタル機器を利用できる人とできない人との間に生じる格差「デジタルデバイド」が生成AIの登場によってさらに顕在化する。

●雇用減と賃金低下が、加速する

チャットGPTによって、平均的な執筆スキルを持つ人々が、論文や記事を書くことができるようになり、ジャーナリストの競争は激しくなり、賃金が低下する。GPS技術とウーバーが出現した時、タクシー運転手が全ての道を知っていることの価値が下がり、その結果、既存のタクシー運転手は大幅な賃下げを経験する。

●デジタルに関する高度な知識を持つ専門職に対する需要が急増する

データサイエンテイスト、サイバー・セキュリテイ専門家などの賃金が高騰する。

既に、IMF は、去年2024年4月に「2024年世界経済見通し[19]」において、AIの採用が世界の中期的成長率を+0.1%~+0.8%高める可能性を指摘している。先進国はより大きなリスクにさらされている一方、新興国・途上国よりAIの利点を活用するための態勢が整っている。また、「AIと仕事の未来」のなかでは、AIが経済に影響を与えるマクロ的な可能性について以下のように述べている。

<AIが経済に影響を与える可能性>

1.[労働代替]これまで労働者が行っていた業務がAIに移行する労働代替の高い分野では労働収入が減少する。

2.[補完性]人間の労働とAIの補完性が高い職業では、AIに代替されないタスクが増加し、そのタスクの重要性が高まる。

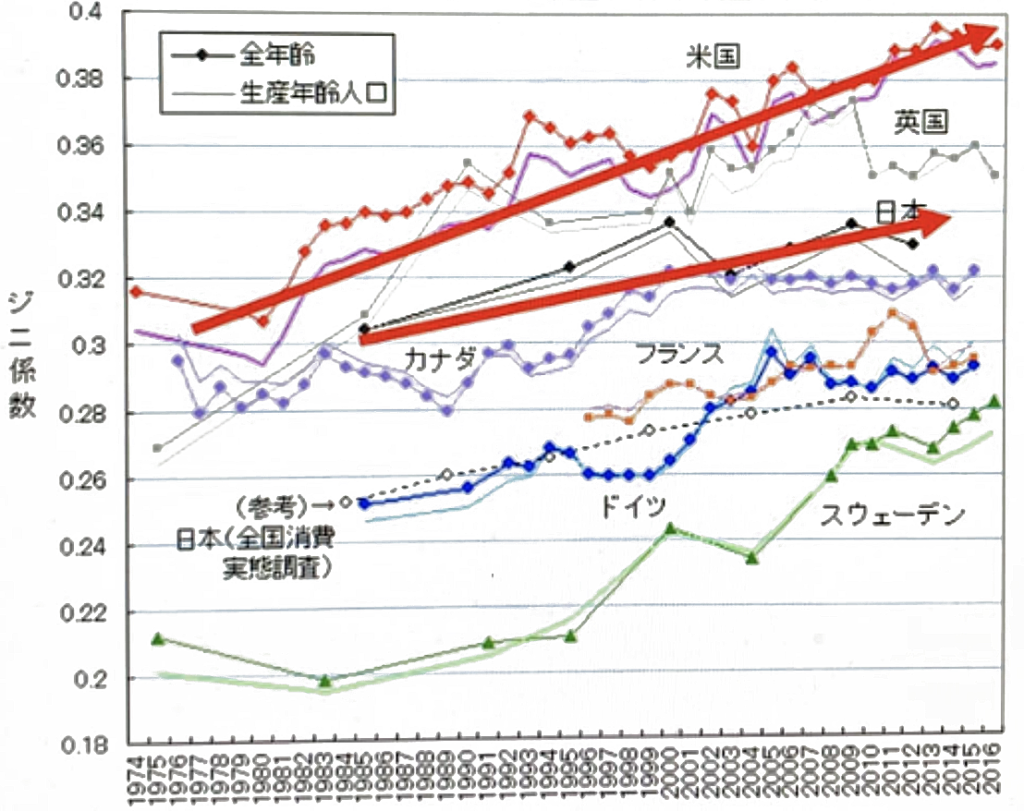

3.[生産性]広範な生産性向上につながり、投資の増加、全体的な労働需要が増加し、労働力の減少の一部を相殺する。また、先行研究によって、情報化の進展により国内で経済格差が拡大していることが明かされた。以下の図は、主要国のジニ係数の推移を示している。AIの社会実装により、情報化の進展がさらに加速され、経済格差がさらに拡大してゆく可能性がある。特に日本は経済格差が顕著である。

(出所)OECD(2018)”Income distribution database”

[18] Brussevich, M., Dabla-Norris, E., Kamunge, C., Karnane, P., Khalid, S. and Kochhar, K.(2018) “Gender, Technology, and the Future of Work,” IMF Staff Discussion Note, No.201818/007.

[19] IMF(2024)” WORLD ECONOMIC OUTLOOK 2024 ” https://www.imf.org/en/Publications/WEO/Issues/2024/04/16/worldeconomic-outlook-april-2024

こうした中、AI時代に、日本の近未来は厳しいと警告する専門家もいる。日本には他の先進国に比べてAIアレルギーの人が多く、古い雇用形態や働き方、人海戦術の仕事の仕方に固執する人が多い。このままでは、日本は、AIの流れに取り残され、企業ひいては日本という船が沈むと警告する。日本企業の情報化投資の大きな特徴は、コスト削減・人員削減を指向する「守りのIT投資」が主流で、新しい商品開発・ビジネスモデルの開発・売り上げ増を指向する「攻めのIT投資」は少ないと指摘。日本では、リスキリングによる組織を超えた労働移転がスムーズに進まないことが問題だとして、特に、以下の3点をAI時代の日本の近未来の懸念事項として、警告している[20]。

<AI時代の日本の近未来の懸念事項>

1)中間層の消滅と経済格差拡大

かつて日本の経済成長を支えた中間層がいなくなることで、経済格差が拡大する。

2)国家財政悪化

セーフティーネットへの国家財政支出が増加することで、国の将来の成長の投資に回す国家財政予算が減少する。

3)人材不足

企業内でリスキリングし、新しい職場に配置転換するのであれば、会社が責任を持って行うが、人の移動が企業を越えて行われる場合、リスキリングし人の移動を担保する人材流動市場がほとんどない日本で、これを全て個人の負担と責任で行うことは極めて厳しい。その結果、データサイエンテイスト、サイバーセキュリテイ専門家などの人材が不足し、企業がグローバルで競争するために必要なスーパースキルを持った人材が不足し、日本経済の成長の足かせとなる。

AIの雇用問題を解決する王道は、新しい事業を興して、失う雇用よりも、もっと大きな雇用を創出することに尽きる。AI時代では、新しいテクノロジーの急速な勃興に必要な大量の人材が、急にはそろわない、という問題が深刻化することは必至である。よって、テクノロジーの発展で余剰になった人材をリスキリングし、新しく必要とする分野にスムーズに移動することが必要である。しかし、日本にはこうしたリスキリングの環境が致命的に欠落している。このままでは、失業の問題よりむしろ、新しい事業が立ち上がらず、日本は、世界の競争に負けてしまう。事態は深刻である。

[20] 岩本晃一(2024)「AIが経済や金融に与える影響」

7.AIと人類の未来との位相~「トランプ2.0」と「スカイネット」リスクの不穏な符合

AIの議論は、国家の国益に関わる短期的な議論に留まらない。さらに全球的視点にたった、本質的かつ永続的な人類の今後の持続可能性そのものにも関わる深刻な問題につながっている。すでに人類社会に内部化してしまったAIの、その近未来図には、さらに本質的な懸念がある。

いま、米国「トランプ2.0」の下でAIの規制緩和が加速し、さらなる生成AIの急速な進化の中で、人類が人間の創造性や判断力そして組織や社会の在り方を再定義する必要性に直面している。

もはや、映画『ターミネーター(The Terminator)』の世界は、絵空事ではない。自らを破壊しようとする存在である人類の殲滅を図る架空AI「スカイネット」は、「トランプ2.0」の先に見えてくる近未来現実であると考えた方がよかろう。「トランプ2.0」の潜在リスクに楽観は禁物である。

映画では、「スカイネット」は、自己進化の機能を備え、あるとき自我に目覚める。これを恐れた人類は「スカイネット」を停止させようとするが、それを自分への攻撃とみなした「スカイネット」は、ロシアに核ミサイルを打ち込んで世界規模の核戦争を誘発。さらに無人兵器で構成した軍隊により人類を絶滅寸前に追い込む。近未来に、この映画そのもの光景が再現するとまでは断言できないものの、その危険性を1つの可能性として念頭に入れながら、今後のAIと人類との最適な位相の在り方を模索することは肝要であろう。あらかじめ、最悪を想定する所作は賢明であろう。

現に生成AIの急激な進化発展拡大は、我々の日常生活やビジネスの在り方そのものを根本から変えつつある。それにはprosとconsの光と影がある。その中で、AIイノベーションは、単なる業務効率化やコスト削減に留まらず、社会全体の価値観や倫理観にも深い影響を及ぼしている。そして、その制御不能な側面が現実のものとなった場合、深刻な問題を引き起こす恐れがある。

特に、AIを民生利用に留まらず軍事利用する場合に「スカイネット」が生まれる危険性は十分にあると警戒する専門家もいる。映画で「スカイネット」が人類を敵とみなしたのは、自己の存続を最優先するよう設定されていたからである。人命を奪うためのプログラムが設定された兵器である「スカイネット」にとって、人類を滅ぼすのをためらう理由はない[21]。その危険性に対して楽観的であってはなるまい。いったん進み始めたAIの開発を止めることはできないし、止められる人もいない。シンギュラリティーが達成されれば、すわ危険なスカイネットが登場することになるとは断言できないが、遅かれ早かれシンギュラリティーが達成されるのは間違いない。現在のAIには、不適切な結果を惹起させないことを最優先に開発されており一定の安全装置が実装しているため、その延長線上に「人類を滅亡させる」という最悪の結果があるとは考えにくいとの楽観的な専門家意見もある[22]が、本当にそう断言できるのか。この楽観論には疑問が残る。少なくとも、人類は、このAIの軍事利用に向かう不可逆的な潮流に無防備であってはなるまい。

「AIが人間の知能を超える」まさに「シンギュラリティー」後の自律性を実装した生成AIの暴走をいかに制御できるのか、いまこそ慎重な対応が必要である。

「制御不能なAI」が引き起こす具体的な問題点・懸念点として以下の諸点が指摘されている[23]。

(1)人間に「反乱」を起こす問題

AIを用いた人間の判断を介さずに殺人が行える自律型殺傷兵器(LAWS)は倫理観と政治的な観点から受け入れられるものではない。AIを民生利用に留まらず軍事利用することを通じて、その後の発展いかんでは、自らを破壊しようとする存在である人類の殲滅を図る「スカイネット」が生まれる危険性は十分にある。「スカイネット」が人類を敵とみなしたのは、自己の存続を最優先するよう設定されていたからである。人命を奪うためのプログラムが設定された兵器である「スカイネット」にとって人類を滅ぼすことに発展する危険性が否定できない。この懸念を、絵空事的な杞憂だとして軽んじてはなるまい。

(2)経済的格差・不均衡拡大の問題

AI技術の急速な発展により、経済的格差や不均衡がさらに加速拡大する懸念がある。一方で、AI技術の専門家や能力を持つ者の需給バランスが変動し、彼らの給与や生活水準が大きく向上する一方で、AIに疎い層との所得格差が拡大する可能性がある。その結果、社会における深刻な格差や分断がさらに拡大する恐れがある。こうしたリスクを未然に予防するためには、普遍的な再教育プログラムの提供や、AI技術の進展に伴う新たな雇用機会の創出が必須不可欠となる。

(3)社会的偏見継承増幅の問題

AIは、その前提となるデータセット段階で性別、人種、年齢などの偏見バイアスが含まれるリスクがあり、その偏見情報を継承し、さらには増幅する傾向がある。それが分割線を強化し、偏見を増幅させ、社会的不平等を加速させる懸念がある[24]。

(4)個人情報漏洩の問題

AI技術、特に生成AIが持つ膨大なデータ解析能力が、ユーザーが自らの知らないうちに個人のデータを不適切に収集、利用することで、ユーザーのプライベートな情報が漏洩する懸念がある。加えて、監視システムや顔認識技術と組み合わさることで、さらに複雑化し、監視社会への一歩を踏み出す危険性もある。その過程で生じるプライバシー侵害は、民間人の生活を脅かし、社会不安を引き起こす原因となる。透明性の欠如を伴う個人情報漏洩は、個人のプライバシー保護に対する重大な脅威となる。

(5)法的・倫理的責任不確定性の問題

AIのガバナンスが確立しておらず、また製造物責任(Product Liability;以下PLと略称)の観点からも、当該損害について補償の仕組みが完備されていないため、AIによって引き起こされた損害に対する法的・倫理的な責任が曖昧で、誰がどのように責任を負うべきなのかが、法的・倫理的にかつ不確定となる問題がある。

なお、ここで問題となっているAIの「制御不能性(uncontrollability)」とは、AIが人間の意図や管理を超え、自己決定的に勝手に行動する状態を意味する。これは、AIが与えられた指令や学習データを超えて独自の意思決定や行動を始める場合に生じる。通常、AIは人間が定めたルールやデータを基に機能する。しかし、学習能力が高いAIは、予測不可能な行動を取り始めることがある。特に、生成AIなどの発展形AIではこの傾向が強く見られる。生成AIの「制御不能性」は、モラルや倫理的な意思決定が関係する場面で特に懸念されている。AIが人間の価値観や社会的規範を理解せずに行動することで、予期せぬ負の影響を与える可能性がある。

AIが制御不能になる要因とそのメカニズムについては、その要因として、AIの自己強化学習機能が挙げられている。自己強化学習を行うAIは、ある目標を達成するために独自に最適な行動パターンを見つけ出し、それを強化していく過程で制御不能になることがある[25]。また、AIの開発者間で共通の倫理基準や安全ガイドラインが確立されていないことも、制御不能化のリスクを高めるとされている。開発者の意図しないAIの振る舞いが、リスク管理の不足により引き起こされる。さらに、複雑なシステム内でのAIの振る舞いは予測が困難であり、この予測不可能性が制御を困難にする。特に、複数のAIが相互作用する環境下では、その相互作用により予想外の行動が生まれることが懸念される。もはや、これは単にAIの問題だけではなく、もはや、まったなしで、人間そのものの在り方についてより深く考えることが求められる社会になってきていると考えてよいであろう。

[21] 映画『ターミネーター3』では、スカイネットは、自らの手足(端末)となる無人兵器による機械軍を作り上げ人間狩りを実行して人類を絶滅寸前にまで追い詰める。最終的には人類側に指導者ジョン・コナーが出現し、彼の率いる反スカイネットゲリラ組織「抵抗軍」によって破壊されたが、はたして、実際には、人類がスカイネットを破壊できるか確証はない。

[22] 大森 敏行(2024)「AIで賢くなるAI、ChatGPTは人類を滅ぼす「スカイネット」に進化するか」

[23] TechSuite(2024)「生成AIを含む人工知能の制御不能の危険性」(2024年4月23日)

[24] 特に、人事採用プロセスにおけるAIの使用は、既存の偏見を反映した結果を生み出すリスクがある。これは、特定の人物やグループに対する不公平な扱いを正当化し、その結果として社会的な緊張や対立を高めるリスクがある。この問題に対処するためには、生成AI含むAIシステムの開発段階で、偏見のないデータセットの使用や、多様な視点と経験を持つ開発者チームの構築が肝要となる。

[25] TechSuite(2024)「生成AIを含む人工知能の制御不能の危険性」(2024年4月23日)

こうした中、気になるのは、最近の「トランプ2.0」の下でAI規制緩和の加速である。

既に前哨戦は、トランプ大統領就任前から始まっていたが[26]、トランプ大統領は、大統領就任直後の2025年1月23日に、AIに対する規制緩和を指示する大統領令を発表した。同令では、人類の繁栄、経済競争力、国家安全保障を促進するために、AIでの米国のグローバルな優位性を維持し、強化することが米国の政策だとして、米国のAIイノベーションの障壁となっているバイデン政権時代の既存のAI規制政策を一気に無効とし、米国がAIのグローバルリーダーシップを維持するために、断固とした行動を取ると述べた[27]。トランプ大統領および側近のイーロン・マスク等の一連の言動には、AIと暗号資産がテック業界の成長ビジネス分野としてさらに大きなプレゼンスを発揮することが読み取れる。

AIはいずれAGI(Artificial General Intelligence=汎用人工知能)として医療、エンタメ、学術、軍事、政治などで人類を主導する可能性がある。その場合、自国で開発されたAGIの質が国家間競争をも左右することになる。他国の開発したAGIを使用することは国家安全保障上の脅威となるため、自国のAI開発を加速させることが国益を守ることにつながる。「Make America Great Again(MAGA=アメリカを再び偉大な国にする)」を標榜するトランプ大統領のとっては不可欠な中核的な政策軸がAIである。そして、トランプ大統領は、米国で最も著名なAIと暗号資産に理解の深いVC投資家デイビッド・サックス(David Sacks)氏を、新設の「ホワイトハウスAI・暗号資産担当高官(Crypto Czar:暗号資産の皇帝)」に任命している[28]。また、サックス氏は、同時に、科学技術諮問委員会(Presidential Council of Advisors for Science and Technology;以下PCASTと略称)の議長として、AIや暗号通貨に関する科学技術政策の立案と実施を指揮することになっている。この委員会人事では、AIや暗号通貨に好意的な専門家の起用が予想されている。特に、同氏はDLT(Distributed Ledger Technology;分散型台帳技術[29];以下DLTと略称)の社会実装を加速させるため、バイデン前大統領時代に誕生したWeb3規制[30]の撤廃を目論んでいる。また、国防についても強い関心を示しており、「AI技術の国防導入(統合)」と「AIイノベーションのためのスタートアップ支援」で大きな役割を果たすとみられている。すでに米国防省では生成AIソリューションを導入するなどDXでのAI活用を進めているが、「トランプ2.0」ではさらに戦術レベル(小部隊指揮や兵士の装備など)でもAI導入が進行すると見られている。この動向は、すでに、「トランプ2.0」の下でAI規制緩和の加速を梃子に、人類は、着実に「スカイネット」が登場する近未来現実に近づきつつあることを意味している。米国「トランプ2.0」の下でAIの規制緩和が加速し、中国やロシアとの軍事技術競合の緊張関係の中で、さらなる生成AIの急速な進化が進み、やがて、人間の関与なしに自律的に攻撃目標を設定することができ、致死性を有する完全自律型兵器LAWSの開発競争を経て、やがて「スカイネット」誕生リスクに繋がって行くことは想像に難くない。

はたしてこうした危機感が、一部の最先端のAI研究者以外で、永田町や霞が関、さらには日本の企業経営者にどこまで高度な解像度をもって共有されているのであろうか。さすがにわが国の優秀な官僚は先刻ご承知のことかとは思うが、いささか、一抹の不安を覚えてはいる。

[26] 米ラスベガスで開催されたテクノロジー見本市「CES」で、今月2025年1月9日、AI政策や国家競争力をテーマにしたセッションが開かれ、そこで、米国の共和党系の米連邦取引委員会(FTC)委員は、トランプ氏の意向を反映しAIの規制緩和を進めたい考えを示した。一方、民主党系の委員は違法行為を抑制するための規制が必要だとの見解を述べ、AI規制緩和をめぐり議論が激しく対立した。このセッションにはFTCで共和党系のメリッサ・ホリオーク委員と、民主党系のレベッカ・スローター委員が登壇し、意見を交わした。元FTC委員で現在は米マイクロソフトのジュリー・ブリル最高プライバシー責任者も登壇した。ホリオーク委員は「前回のトランプ政権は(企業の)成長に積極的だった。今回も技術革新を促す規制環境になるだろう」との見方を示した。AIの開発競争で「米国は最前線であり続ける」と強調し、「規制に関する決定が技術革新を促進し、決して妨げないようにしたい」と語った。一方、スローター氏は「技術革新は米国の消費者と労働者を助ける」とホリオーク氏の発言に一部同意したうえで、「革新を妨げる線引きについての意見は異なる」と話した。「違法行為に対する抑止力は必要だ」と述べ、企業に対して厳しい姿勢で向き合うべきだと示唆した。トランプ氏はFTC次期委員長に、企業への規制に慎重なアンドリュー・ファーガソン現委員を昇格させる。リナ・カーン現委員長に比べると企業への反トラスト法(独占禁止法)を巡る圧力が弱まるという見方がある。FTC委員らの議論の後は米テクノロジー企業の幹部らが登壇した。米新興オープンAIで北米の公共政策を率いるチャン・パーク氏は「次期政権と議会の発足で、規制環境についての理解は変える必要がある」と政策変更が起きるという見通しを示した。一方で「米国が優位性を維持することに重点を置く点は変わらない」とも述べた。(出所)日本経済新聞(2025)「トランプ2.0、AI規制は緩和か強化か 米当局がCESで議論」(2025年1月10日)

[27] トランプ政権1期目では、政治的な意図や国家安全保障上の懸念から、テック業界に関して否定的であった。2019年7月には「規制を受けない仮想通貨は麻薬取引や他の不法活動などの違法行為を容易にし得る」と旧Twitter(現X)に投稿していた。AIに関しても、ディープフェイクを生み出すリスクを訴え、規制法(国防権限法の一部)にも署名した。しかし、「トランプ2.0」では一転して最新テックを重視し、イノベーションに舵を取っている。今回のトランプの大統領令に基づく指示は大きく2つに分かれる。1つ目は、行動計画の策定だ。同令の発令から180日以内に、大統領補佐官(科学技術政策担当、APST)、AI・暗号資産担当特別補佐官、大統領補佐官(安全保障問題担当、APNSA)に対して、AIで米国のグローバルな優位性を維持・強化するための行動計画を策定し、大統領に提出することを命じた。2つ目は、過去の大統領令の見直しだ。今回の大統領令では、APSTらに対して、2023年10月にジョー・バイデン大統領(当時)が発表したAIの安心、安全で信頼できる開発と利用に関する大統領令(2023年11月1日記事参照)に基づいて取られた全ての政策、指令、規制などを直ちに見直し、AIにおける米国のグローバルな優位性を維持し強化する政策の障壁になっている場合は、それらを一時停止、修正、撤回などの提案をするよう指示した。バイデン氏による大統領令は、AIの安全性評価や、公平性と公民権に関するガイダンス、AIが労働市場に与える影響に関する調査を義務付けるもので、米国で初めての法的拘束力のある行政措置とされていた。バイデン氏は、先端AI技術の進歩が近い将来、国家安全保障や外交政策に重大な影響を及ぼすなどとして、開発を促進すると同時に、ガバナンスの強化にも取り組んできた。他方で、産業界からは過度な規制を牽制する声も上がっていた。2024年11月の大統領選挙でトランプ氏の勝利が確実になると、関係団体はトランプ氏による規制緩和を期待する声明を発表していた。(出所)JETRO(2025)「トランプ米大統領、AIに対する規制緩和を指示する大統領令発表」(2025年1月27日)

[28] デイビッド・サックス(David Sacks)氏は、クラフト・ベンチャーズの共同創業者でイーロン・マスク氏の元同僚(通称PayPalマフィア)。バンス次期副大統領とも親しい。バイデン政権時制定された米国のAI規制のためのWeb3規制に反対の立場を示している。トランプ氏は政権の要職にシリコンバレーで最も著名な支援者・資金調達者の1人であるサックス氏を起用した。トランプ氏は自身のソーシャルメディア「トゥルース・ソーシャル」への投稿で、「サックス氏は政権のAI・暗号資産分野の政策を主導する。この二つの分野は今後の米競争力にとって極めて重要だ。サックス氏は米国が両分野で明らかに世界のトップに立てるよう力を注ぐだろう」と言及している。、また、サックス氏が大統領科学技術諮問委員会のトップも務めると明らかにしている。(出所)Stephanie Lai(2024)” Trump Names David Sacks as White House AI and Crypto Czar”(December 6, 2024;Bloomberg)

[29] 「分散型台帳技術」は、英語でDistributed Ledger Technologyといい、その頭文字を取ってDLTとも呼ばれている。従来の一般的な情報システムやデータベースでは、必ず中央管理者が存在し、中央集権型サーバーによってデータベースや台帳情報が一元管理されているが、DLTは原則として中央管理者が存在せず、中央集権型のサーバーも存在しない。DLTは、台帳やデータベースを共有し、ネットワーク上の各コンピューター(ノード)が共通の台帳情報を保有している。DLTでは、各コンピューターがPeer to Peer(P2P)ネットワークによってつながっているのが特徴で、ネットワーク参加者全員で台帳を管理する。DLTは各コンピューターが個々に同じ台帳を保有し、P2Pネットワークによって互いに情報をやり取りし合いながら、台帳情報を更新していく分散型の台帳管理技術である。ビットコイン等暗号資産(仮想通貨)の基幹技術となるブロックチェーン技術はDLTである。

[30] 「Web3.0」は、ブロックチェーン技術に基づいて実現された革新的なテクノロジーで、非中央集権化(Decentralization)、相互検証可能な透明性(Transparency)、自己主権性(Self-sovereignty)、自律性(Autonomy)の4つの特徴を持つ。世界では、①NFT取引、②分散型金融(DeFi)、③ゲームと金融の融合(GameFi)など、暗号資産やNFT等のトークンを用いた多様なスタートアップが誕生。さらに④メタバースとの掛け合わせも含めた新たなデジタル経済圏の創出に向かっている。世界各国では、個人情報やデータ保護などの課題に対応しWeb3の健全な発展を促す目的で法的規制が設けられている。

8.AIと気候危機との位相

昨年2024年11月にアゼルバイジャンのバクーで開催されたCOP29(国連気候変動枠組条約第29回締約国会議)では、初めて気候変動に対するAIの功罪が議論された。

AIは、気候危機問題にとって、アンビバレントな存在である。加害者である顔と、解決者の顔の2つの顔を持っている。

まず、AIの気候危機への「加害者」の側面であるが、AIが気候変動に与える負の影響があることは、あまり知られていない。ChatGPTやMidjourneyなどのツールを動かすデータセンターがAIの基盤を支えている。データセンターは、膨大な電力を消費する。生成AI技術は急速に進化しており、言語処理のみならず、画像や映像の処理能力も実用レベルに達し、その可能性は大きく広がってきており、生成AIの利用が急速に世界全体に普及している。その普及に伴い計算処理量が急増している。その結果として世界中で電力消費量が増加している。発電量の増加と共に化石燃料の消費も増加し、温室効果ガス排出が増加し、気候危機を加速させる[31]。

国際エネルギー機関(International Energy Agency:以下IEAと略称)は、来年2026年のデータセンターでの電力消費量が、2022年比で最大2.3倍になるとの試算を示している[32]。

生成AIの普及が与える日本の電力需要への影響について先行研究もある[33]。生成AIの社会浸透と基盤モデルの大規模化という2つの要因により、5年後の2040年の日本の総計算量は2020年比で最大十万倍以上に達し、その影響で、生成AIの学習や推論が行われるデータセンターなどICTセクターで、電力需要がさらに急増する恐れがあると予想している。

電力消費の急増を抑えつつ生成AIの利活用を実現するためには、省エネ型の生成AIの活用や半導体技術開発等によって電力効率の向上を図ることが求められている。そして、AIの環境影響に関する透明性の向上も必須不可欠となる。

今年2025年中には、こうした電力消費の急増を抑えつつ生成AIの利活用を実現するための自主的な取り組みが、各国政府や国連といった政府間組織による法規制というかたちで実施されるとされている[34]。研究の進展、社会の認識向上、規制の強化により、AIの環境負荷を正確に把握し、その削減に向けた具体的な対策が講じられるようになることが期待されている。

しかし、AIの環境負荷は、電力消費増に伴う温室効果ガス排出量増加の問題だけではに。多岐に及ぶことにも留意が必要である。

水問題もある。過熱を防ぐためにデータセンターでは数百万ガロンの淡水が必要で、アリゾナ州やスペインなどでは、実際に、枯渇が懸念される帯水層から大量の淡水を消費していることが問題になり、地域社会とデータセンター運営企業との間で水資源を巡る対立が生じている。台湾では100年来最悪とされる干ばつに見舞われるなか、政府は限られた水資源の配分を迫られ、農業用水よりも、需要増への対応を迫られる半導体製造工場への供給を優先する判断を下し問題となっている。また、データセンター設備の基幹部分となるハードウェア製造に数トンのレアアースメタルが必要となる。電力のみならず、AIの急激な拡大は、様々な地球環境への負荷を増大させている。

次に、AIの気候危機問題への「解決者」の側面であるが、気候変動対策におけるAIの果たすプラスの役割は、広範かつ多岐に及び、枚挙に暇はない。気候変動対策におけるAIの貢献についての直近の先行研究[35]がある。それを参照しながら、以下、論点整理したい。

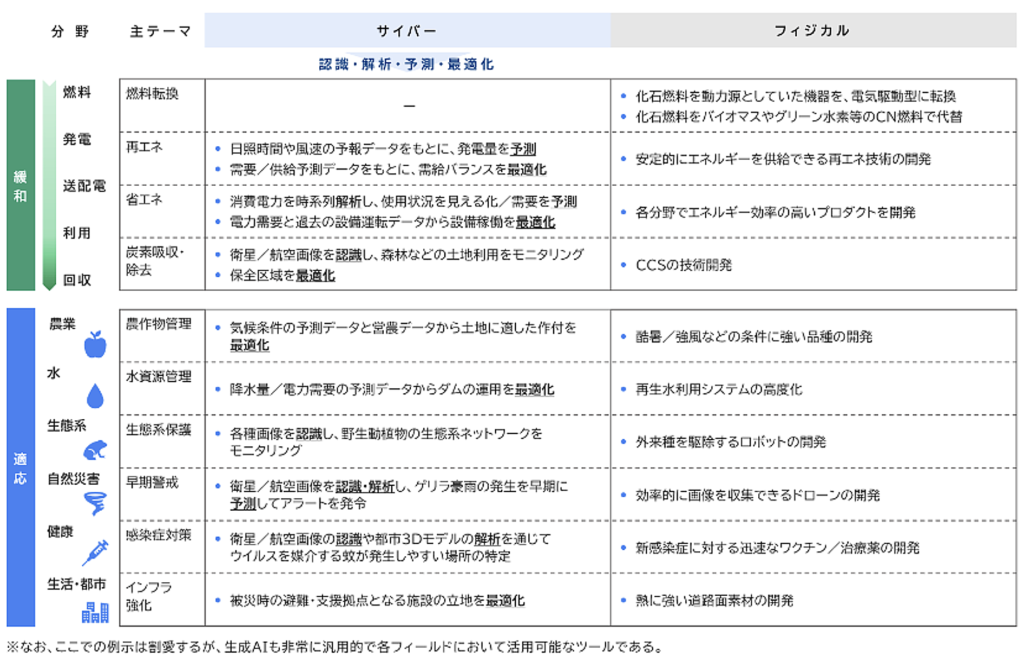

AIは、気候危機問題の解決に対して「サイバーソリューション」と「フィジカルソリューション」という2種類のソリューションを提供している[36]。まず「サイバー」での貢献としては、AIが出力する情報が「認識・解析・予測・最適化」の4つの役割で直接的に気候危機問題解決に貢献する。例えば、気候危機の緩和策でAIの役割が果たす好事例としては、変動型の再生可能エネルギーの需給変動問題を解決するためにAIは日照時間や風力の予想データをもとに発電量を予測し、需要・供給予測データをもとに需給バランスを最適化する貢献等がある。方や、「フィジカル」での貢献としては、AIが、ロボット等のハードウエア開発や、プロダクト開発・運用面で貢献する。

気候変動対策におけるAIの貢献の事例は多岐に及び、枚挙に暇はないが、以下の図は、気候変動対策の代表的な分野とAIによるソリューションの一例をマッピングしたものである。

(出所) 三菱総合研究所(2025)「気候変動対策でAIにかかる期待」

(三菱総研 研究・提言レポート「AIが切り拓く気候変動対策の未来像」)

[31] Sasha Luccioni(2025)「AIの環境負荷が気候変動対策の足かせとなる」(WIRED UK magazine)

[32] The Copernicus Climate Change Service(C3S), ”Copernicus: 2024 virtually certain to be the warmest year and first year above 1.5°C” https://climate.copernicus.eu/copernicus-2024-virtually-certain-be-warmest-year-and-first-year-above-15degc

[33] 三菱総合研究所(2024)「生成AIの普及が与える日本の電力需要への影響」(三菱総研 研究・提言レポート)https://www.mri.co.jp/knowledge/insight/policy/i5inlu000000np1p-att/nr20240828pec-1.pdf

[34] Sasha Luccioni(2024)“AI is ‘accelerating the climate crisis,’ expert warns”

[35] 三菱総合研究所(2025)「気候変動対策でAIにかかる期待」(三菱総研 研究・提言レポート「AIが切り拓く気候変動対策の未来像」)https://www.mri.co.jp/knowledge/column/20250130.html

[36] 三菱総合研究所(2025)「AIが切り拓く気候変動対策の未来像」(三菱総研 研究・提言レポート)

AIによる気候危機問題のソリューションは、日本の活躍の場でもある。先行研究は、特に、気候危機対策の適応ソリューションに関して、日本の強みが発揮できる有望な領域があるとしている[37]。その象徴的な技術が、「早期警戒システム」と「衛星画像利用」である。

「早期警戒システム」は、ゲリラ豪雨と洪水の発生を予測し、避難を促す警報システムなど、災害の発生を早期に警告するシステムである。先のCOP29では最貧国の人々も含めた全ての人がアクセスできる早期警戒システムを実装する必要性が指摘され、世界人口の96%をカバーしているモバイル通信ネットワークを介したアラート発信が、早期警戒システムの実装では有効だと考えられ「Early Warnings for All」というイニシアチブが注目を集めた[38]。日本は多様な自然災害が発生する環境でデータの蓄積もあるため、実績とソリューションの輸出国として一大プレーヤーになるポテンシャルがある。

「衛星画像利用」は、広範なデータ収集が必要な気候変動の影響を把握するための有力な武器となる。衛星画像や航空画像の画像認識はAIの深層学習との親和性が高く、技術開発の進展が期待できる。日本は高性能なセンシング技術を有しており、収集したデータと衛星画像を基にAIを統合したソリューションを開発することで、この領域での日本の競争力を大いに高めることができる。

日本は、台風や地震等の自然災害が多発する世界有数の「災害大国」である。その地域特性から、防災・減災のためのインフラ整備を進め、国土強靭化に長年取り組んできている。したがって、経験値も豊富で、フィジカル面に強みを有している。ここに、AIやIoTを活用してサイバー面を強化することで、導入コストを抑えながらも、性能や信頼性、さらに長期的なサポートで差別化された気候変動対策の仕組みを開発することができる日本の強みがある。このような取り組みを通じて、日本は気候危機問題の適応ソリューションの分野でトップランナーとなり得る。

米国トランプ新大統領による米国の「パリ協定」脱退等、「トランプ2.0」に象徴される「反・脱炭素」の不穏な空気感も醸成されつつある不安定な国際情勢下、気候危機対策の減速が危惧されているが、世界のマジョリティーは、官民とも、脱炭素に向けたモメンタムに揺るぎはない。こうした中、世界中に燎原の火のごとく急激な爆発的拡大を見せているAIの潜在力を、気候危機対策に有効に生かすことは、人類にとって最優先課題である。この課題に、日本が貢献できる分野は広く、また、グローバルサウスも含めた世界からの期待も大きい。

AIと気候危機との位相を射程にした日本の貢献は、必ずしや、日本の存在感と今後の継続的な持続可能性を担保することになり、AIによる気候危機問題のソリューション分野における日本のプレンゼンスの確立は、日本の技術なくして気候危機問題の解決はできないと世界が認識することによって、日本の安全保障上の担保にもなる意味でも、やがては、日本の未来にとって明るい材料となるはずだと確信している。

[37] 三菱総合研究所(2025)「COP29で強調されたテーマと日本の可能性」(三菱総研 研究・提言レポート「AIが切り拓く気候変動対策の未来像」)

[38] World Meteorological Organization(2024)“COP29: Harness digital technology to reach everyone with early warnings”( 16 November 2024)https://wmo.int/media/news/cop29-harness-digital-technology-reach-everyone-early-warnings

9.AIと人類の未来への提言 ~軍事利用でなく気候危機対策と平和構築への利用促進を

今人類が抱えている「パンドーラーの箱」の底にはささやかな「エルピス(希望)」が残っている。

その「希望」は、AIを軍事利用ではなく、気候危機対策や平和構築等に利用することによってのみ実現する。AIを軍事利用に向けた瞬間から、瞬く間に「希望」は儚く消え、その先に待ち受けているのは「悪夢」である。その先の終点には、人類の滅亡が待っている。ろくな選択肢ではない。

今、人類の眼前には、分岐点がある。その分岐に、未来に繋がる2つの道がある。1つは、「シナリオA」の道。もう1本の道は、「シナリオB」の道である。どちらの道も、一方通行の道で、一旦、踏み入れたら、もはや引き返すことはできない。

「シナリオA」は、AIの軍事利用することを禁止し気候危機対策や平和構築等に活かす道であり、もう1つの「シナリオB」は、AIの軍事利用を容認する道である。まだいまなら、いずれのシナリオも選択可能である。どちらの道にも、行くことができる。いまが正念場である。

前者「シナリオA」の道は、人類共通の脅威である気候危機問題をAIを最大限有効活用して早期全面解決を目指すの道である。気候危機問題解決に向けた「脱炭素化」を全球的に迅速に完遂させるために、AIが不可欠である。AIが道祖神の役割を果たす。その道程には、「早期警戒システム」や「衛星画像利用」等の日本の強みが発揮できる有望な機会が多々ある。この道は、単に気候危機問題を解決するばかりではない。かつて化石燃料の争奪のために繰り返してきた不毛な戦争や紛争の撲滅と恒久的平和構築にも繋がる「希望の道」である。まさに日本の活躍の場である。

方や、後者「シナリオB」は、目下、「トランプ2.0」が画策しているAIの軍事利用の道である。その先に待っているのは、人間の関与なしに自律的に攻撃する致死性を有したLAWSの世界だ。

その先には、中国やロシア等との不毛なLAWSの開発競争が永遠に展開する無間地獄のような修羅場が待ってる。それは、全人類の分断と対立をさらに加速させ、深刻な悲劇に導く。百害あって一利なしである。そして、やがて人類を滅亡させる「スカイネット」が登場する。「スカイネット」は、何度過ちを戦争と言う罪を犯しても反省も学習もせず、同じ過ちを性懲りもなく何度も繰り返す人類の愚行を冷静に観察した結果、もはや人類の行く先に希望はないと判断する。人類に対する最後通告として人類滅亡と言う最後通告を下す。そして、人類は、カタストロフな最悪の結末に行く。つまり、「シナリオB」は、選択してはならない「悪夢」のシナリオに他ならない。

そのいずれかを選択するのは人類次第である。

まだ「エルピス(希望)」はある。さあ、どうするか。

1つ明らかなことがある。それは、いま、人類は分岐点に立っているという事実である。いまなら、まだ遅くはない。いまなら選択できる。この選択こそが、大事なのである。

(end of documents)